5月28日、Metaは革新的なマルチモーダル大規模モデルMulti-SpatialMLLMをリリースしました。これは、奥行き知覚、視覚対応、動的知覚という3つのコアコンポーネントを統合することで、従来の単一フレーム画像分析の限界を打ち破ることに成功しました。このモデルは、Meta FAIR チームと香港中文大学が共同で開発しました。これは、ロボット工学や自動運転などの分野における複雑な空間理解の緊急のニーズに対応することを目的としています。これまで主流のモデルは、基本的な空間推論におけるエラー率が高く、左右の方向を区別することさえ困難でした。

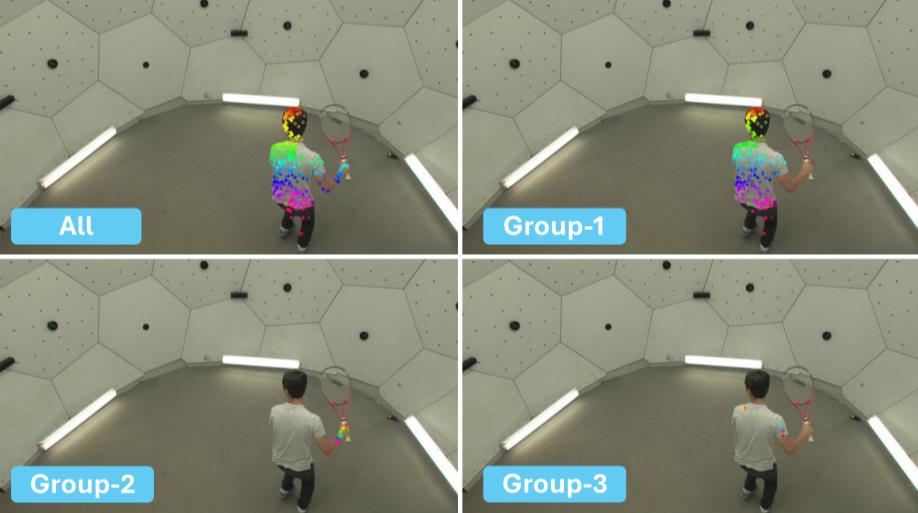

研究チームは、Aria Digital TwinやPanoptic Studioなどの高精度3D/4Dシーンデータを統合し、GPT-4oを使用して多様なタスクテンプレートを生成することで、2,700万サンプルを含むMultiSPAデータセットを革新的に構築しました。奥行き知覚やカメラモーション知覚などの 5 つの特別なトレーニングを通じて、マルチフレーム動的推論におけるモデルのパフォーマンスが大幅に向上しました。テストデータによれば、MultiSPAベンチマークテストにおける精度はベースラインモデルより平均36%高く、高難易度のカメラモーションベクトル予測タスクでも18%の精度を達成し、従来の方法のランダム推測レベルをはるかに上回っています。

さらに印象的なのは、このモデルが BLINK ベンチマークで独自のシステムをほぼ 90% の精度で上回り、標準的な Visual Question Answering (VQA) タスクで最先端のパフォーマンスを維持し、空間に特化したトレーニングによってその汎用性が損なわれないことを実証していることです。この画期的な進歩は、マルチモーダル大規模モデルにとって、静的理解から動的なシーン認識への重要な転換点となり、実際の環境でのスマート デバイスの相互作用に新たな可能性をもたらします。テクノロジーが進化するにつれ、Meta はこれを活用して、特に近日発売予定の Hypernova スマート グラスなどの端末製品で実用的なアプリケーションを実現することにより、AI ハードウェア エコシステムにおける主導的地位を強化する可能性があります。