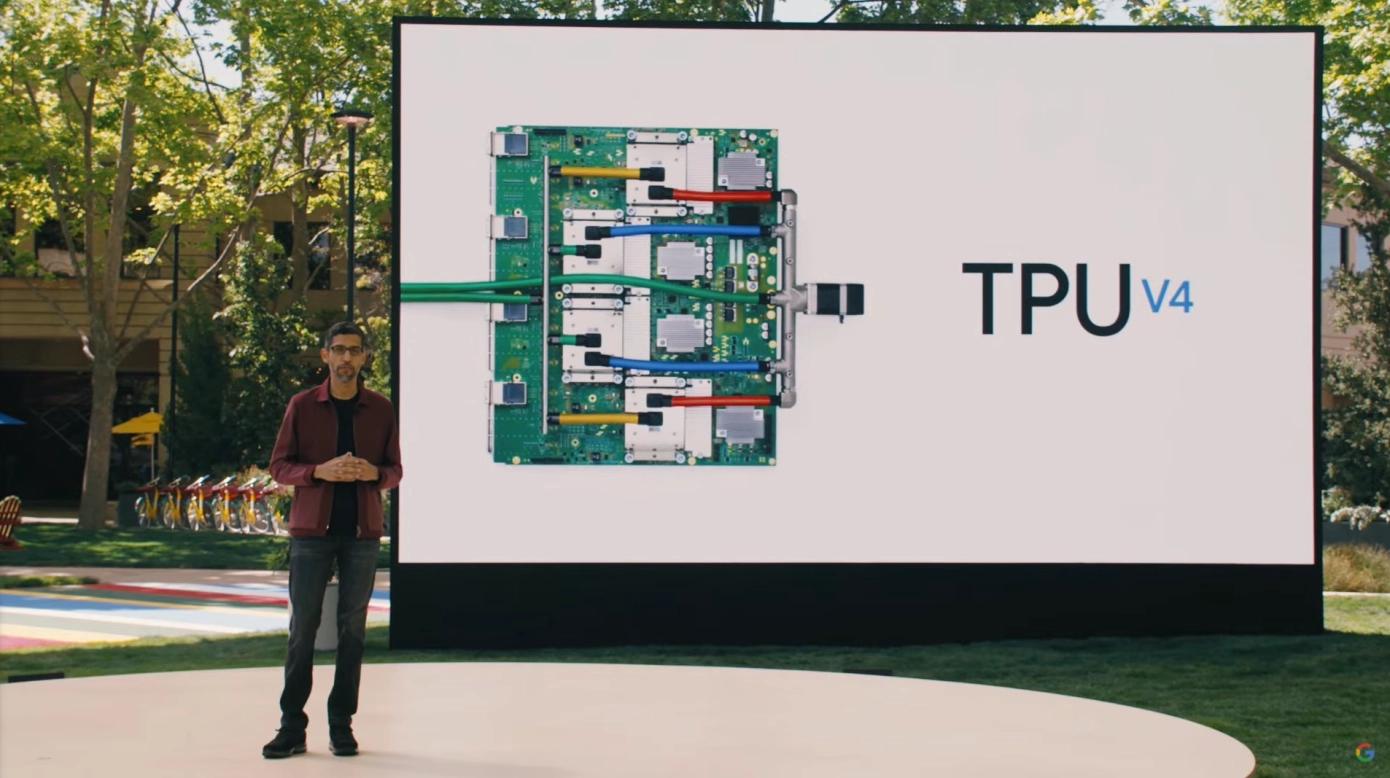

OpenAIは、初期テストにもかかわらず、GoogleのTPUチップを大規模に採用するつもりはないと述べた。報道によると、マイクロソフトが支援するこのAI企業は、アルファベットのテンソル処理装置の一部を試験的に導入していることを確認したが、大規模に導入する計画はない。 TPU チップ(テンソル プロセッシング ユニット)は、Google が機械学習タスク専用に設計したカスタマイズされた ASIC チップであり、ニューラル ネットワークのトレーニングと推論を加速するように設計されています。 TPU はデータフロー駆動型アーキテクチャを採用し、効率的な行列乗算パイプライン計算を実現し、メモリアクセスの遅延を削減します。

OpenAIは、モデルのトレーニングと推論をサポートするために、引き続きNvidiaのGPUとAMDのAIアクセラレーターに依存していくと述べ、これら2つのチップメーカーの製品は「実績のあるパフォーマンス」と「既存の供給契約」を持っていると主張した。

先週末、OpenAIが一部のタスクにGoogleのAIチップを使い始めたとメディアが報じたが、情報筋によると、これらはTPUのローエンドバージョンにすぎず、Googleの最も高度なチップ(Gemini大規模言語モデル用に設計)は依然として自社使用のために確保されているという。

Google Cloud との最近の契約は OpenAI のより広範なインフラストラクチャのニーズに対応するものですが、同社は短期的には大量のコンピューティング能力を TPU プラットフォームに移行する予定はないことを明確にしています。

投資家やアナリストはこれまで、TPU の潜在的な提携は OpenAI が Nvidia の代替を模索している兆候だとみており、モルガン・スタンレーのストラテジストは、この動きが Google ハードウェアの市場競争力を効果的に証明するものになるとさえ考えている。

しかし、OpenAI の声明は、既存のチップ パートナーの粘り強さと、新しいハードウェアを大規模に導入することの複雑さを浮き彫りにしています。 AIコンピューティング能力の需要が高まり続ける中、OpenAIはTPUアーキテクチャに完全に切り替えるのではなく、既存のGPU-TPUハイブリッドテストに基づいて徐々に拡張していく傾向にあるようです。

OpenAIのチップロードマップは、NvidiaとAMDが引き続き主要サプライヤーとなることを市場に示すものであり、TPU技術の継続的な進歩にもかかわらず、GoogleがAIハードウェア市場シェアを拡大する余地は制限される可能性がある。

投資家は、TPU の使用法の変化や新しいサプライヤーへの多様化の兆候を探るため、OpenAI の次回のインフラストラクチャ アップデートと Google Cloud の収益報告を注視するでしょう。